Big Data Nedir? Nasıl Üretilir?

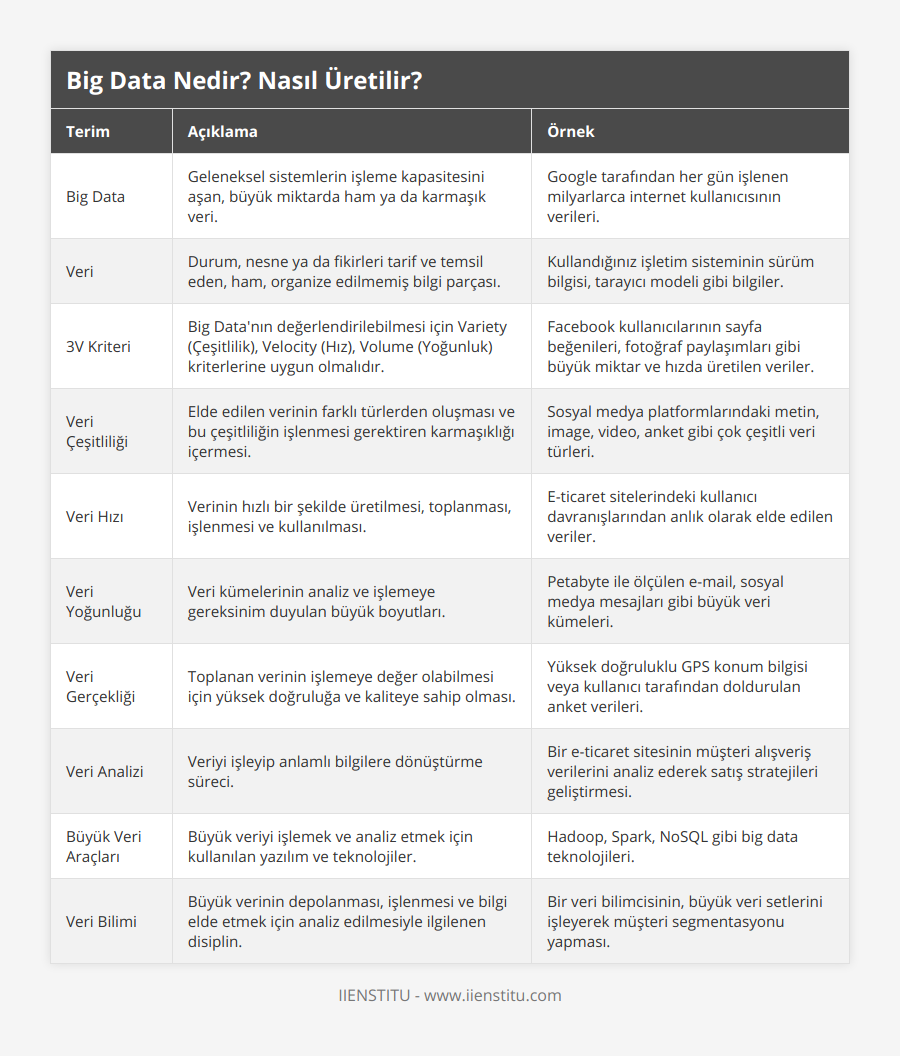

| Terim | Açıklama | Örnek |

|---|---|---|

| Big Data | Geleneksel sistemlerin işleme kapasitesini aşan, büyük miktarda ham ya da karmaşık veri. | Google tarafından her gün işlenen milyarlarca internet kullanıcısının verileri. |

| Veri | Durum, nesne ya da fikirleri tarif ve temsil eden, ham, organize edilmemiş bilgi parçası. | Kullandığınız işletim sisteminin sürüm bilgisi, tarayıcı modeli gibi bilgiler. |

| 3V Kriteri | Big Data'nın değerlendirilebilmesi için Variety (Çeşitlilik), Velocity (Hız), Volume (Yoğunluk) kriterlerine uygun olmalıdır. | Facebook kullanıcılarının sayfa beğenileri, fotoğraf paylaşımları gibi büyük miktar ve hızda üretilen veriler. |

| Veri Çeşitliliği | Elde edilen verinin farklı türlerden oluşması ve bu çeşitliliğin işlenmesi gerektiren karmaşıklığı içermesi. | Sosyal medya platformlarındaki metin, image, video, anket gibi çok çeşitli veri türleri. |

| Veri Hızı | Verinin hızlı bir şekilde üretilmesi, toplanması, işlenmesi ve kullanılması. | E-ticaret sitelerindeki kullanıcı davranışlarından anlık olarak elde edilen veriler. |

| Veri Yoğunluğu | Veri kümelerinin analiz ve işlemeye gereksinim duyulan büyük boyutları. | Petabyte ile ölçülen e-mail, sosyal medya mesajları gibi büyük veri kümeleri. |

| Veri Gerçekliği | Toplanan verinin işlemeye değer olabilmesi için yüksek doğruluğa ve kaliteye sahip olması. | Yüksek doğruluklu GPS konum bilgisi veya kullanıcı tarafından doldurulan anket verileri. |

| Veri Analizi | Veriyi işleyip anlamlı bilgilere dönüştürme süreci. | Bir e-ticaret sitesinin müşteri alışveriş verilerini analiz ederek satış stratejileri geliştirmesi. |

| Büyük Veri Araçları | Büyük veriyi işlemek ve analiz etmek için kullanılan yazılım ve teknolojiler. | Hadoop, Spark, NoSQL gibi big data teknolojileri. |

| Veri Bilimi | Büyük verinin depolanması, işlenmesi ve bilgi elde etmek için analiz edilmesiyle ilgilenen disiplin. | Bir veri bilimcisinin, büyük veri setlerini işleyerek müşteri segmentasyonu yapması. |

Big data, geleneksel sistemlerin işleme kapasitesini aşan, büyük miktarda ham ya da karmaşık veriyi ifade eder. İnsanların dijital teknolojileri kullanmaya başlamasından bu yana her geçen gün biriktirdikleri verinin boyutu, veriyi saklamak ve işlemek için kullanılan donanımların kapasitesini fazlasıyla aşmaktadır. Bu sorunlar veri bilimi, veri madenciliği alanında çalışan veri analisti uzmanlarca çözülmeye çalışılmaktadır.

Aylık 2,45 milyar aktif kullanıcısı bulunan Facebook, kullanıcılarının ürettiği tüm bilgileri işlemektedir. Sayfa beğenileri, resim, fotoğraf paylaşımları, reklamları izleme süreleri ve daha pek çok şey. Google milyarlarca web sitesine ait katrilyonlarca kayıtlı sayfa içinden aradığınız sonuçları listeliyor. Kullanıcılarının arama alışkanlıklarını, konum, dil ve sair tüm bilgilerini kaydediyor ve işliyor. Dünya genelinde toplam 4,5 milyar internet kullanıcısının gün içinde ürettiği bu bilgilerin boyutunu hayal etmeye çalışın. İşte Big Data (Büyük Veri) budur.

Veri Nedir? Nasıl Üretilir?

Veri, durum, nesne ya da fikirleri tarif ve temsil eden, ham, organize edilmemiş bilgi parçasıdır. Bilginin yeniden yorumlanabilmesi ya da işlenebilmesi için kullanılan parçalardır. Veri, tecrübe, bilgi, ya da big data (büyük veri) gibi kavramlar söz konusu olduğunda veri tek başına bir anlam ifade etmez. Bilgiye dönüşebilmesi ve kullanışlı olabilmesi için miktar, hız, çeşitlilik ve gerçeklik (kalite) bağlamında işlenmesi gerekir.

Bu yazıya ulaşmak için yaptığınız araştırma sürecinde veri ürettiniz. Okurken de veri üretmektesiniz. Kullandığınız işletim sisteminizin sürümünden diline, tarayıcınızın modelinden ekran boyutuna, arama motorlarında kullandığınız anahtar kelimelerden paylaştığınız konumunuza ve geçirdiğiniz süreye kadar her şey bir veridir. Bu veriler, veri analisti olarak tanımlanan uzmanlarca işlenmektedir.

Sosyal medya araçlarında konum bilgisini paylaşan yüz milyonlarca kişinin yarattığı devasa bir veri topluluğu vardır. Milyonlarca müşterisi olan alışveriş siteleri, sosyal medya ortamları, kullanıcılarının tüm işlemlerini kaydetmektedir. Toplanan bu veriler, güvenlik, pazarlama, istatistik, bilimsel araştırmalar gibi alanlarda kullanılmaktadır.

Veri topluluğunun big data olarak değerlendirilebilmesi için 2000’li yıllarda ortaya atılan ve 3V olarak anılan, Variety (Çeşitlilik), Velocity (Hız), Volume (Yoğunluk) kriterlerine uygun olmalıdır. Elde edilen verinin işe yararlığı verinin çeşitliliği ile ilgilidir. Bu veriye hızlı bir biçimde ulaşmak ve verinin üretilme hızı bir diğer kriterdir. İşlenecek ve anlamlı sonuçlar üretecek verinin yoğunluğu (ya da karmaşıklığı) da yüksek olmalıdır. Karmaşıklığı yüksek olan düşük yoğunluklu veriler de big data olarak değerlendirilir.

Big Data Çeşitliliği

Çeşitlilik, verinin yoğunluğunu artıran bir etkendir. Çok çeşitli kaynaklardan gelen veri big datayı oluşturur. Gelen bu verileri işlenmiş, yarı işlenmiş ya da işlenmemiş veri olabilir. Verinin türündeki çeşitlilik gelişmiş algoritmalar gerektirir. Verinin çeşitliliği ve yoğunluğu kadar hızı da işletmeler açısından önemlidir. Hızlı bir şekilde üretilmesi ve elde edilmesinin yanı sıra hızlı bir şekilde işlenmesi ve kullanılması gerekir.

Elde edilen veri, pek çok durumda hızlı bir şekilde değerini yitirecektir. Veri analizi ne kadar hızlı olursa sorunlar o denli hızlı çözülür ya da pazar değişikliklerine ayak uydurulabilir. Değişime ayak uyduramamış fikirlerin, toplumların yok olup gitmesinin nedeni; veriyi yeterince hızlı üretememiş, işleyememiş olmalarıdır.

Veri yoğunluğu, terabayt ve petabayttan daha büyük olan, analiz edilmesi ve işlenmesi gereken veri kümelerinin boyutunu ifade eder. Verinin büyüklüğü ya da karmaşıklığı geleneksel depolama ve işleme yeteneklerinden fazlasını gerektirir. İlk ortaya çıkışından bu yana big data kriterleri zamanla artış gösterdi. Bunlardan biri de verinin gerçekliği ya da kalitesidir. Üretilen verinin yüksek doğruluğu genel sonuçlara anlamlı bir şekilde katkıda bulunur. Düşük doğrulukta ki veriler yüksek miktarda anlamsız veri içerir.

Değerli olmayan bu anlamsız veri setlerine bilgi kirliliği ya da gürültüsü denir. Büyük yoğunluk, yüksek hız, çok çeşitlilik ve yüksek doğruluktaki veri kümeleri, anlamlı sonuçlar üretmek amacıyla geliştirilmiş program ya da programlama dilleri ile işlenmelidir. Verilerin bu özellikleri bağlamında, veri kümelerinin depolanması, işlenmesi ve veri analizi ile ilgilenen veri bilimi, büyük veri olarak karşımıza çıkıyor.

Büyük Veri Araçları

Big data (büyük veri) sistemlerinin ne kadar büyük veri ürettiği ve işlediği hakkında birkaç kayda değer bilgi paylaşalım.

IBM tarafından yapılan bir açıklamaya göre; internet kullanıcıları her gün 2.5 kentilyon byte veri üretmekteler.

Son 2 yılda üretilen bilgi toplam bilginin %90’ını oluşturmaktadır.

Facebook, 45 milyardan fazla fotoğrafı kullanıcı veritabanında saklıyor.

Bugün, petabytelarla ölçülen ve büyük olarak nitelenen veri yoğunluğu, gelişen teknoloji sayesinde yarın normal büyüklük olarak nitelenecek. Teknik olarak büyük veri, teknolojik altyapımızı zorlayan veri yoğunluğudur. Bu verilerin bir yerde toplanıp, kullanılabilir hale getirilmesi için işlenmesi gerekiyor. Geleneksel teknoloji ile bu ihtiyaçlar karşılanabilir değil. Yapılan veri analizleri, big data yöntemleri ile daha detaylı ve çözümleyici hale getirilebiliyor.

Kontrol edilmesi her geçen gün daha da zorlaşan büyük veri ile birlikte yeni araçlar da geliştirilmektedir. İşletmelerin ihtiyaçlarını karşılamak amacıyla Hadoop, Hive, Kafka gibi araçlar kullanılır. Pek çok açık kaynak kodlu sistemler geliştirilmiştir. Büyük veri projelerini destekleyen Apache Software Foundation adında bir vakıf da bulunmaktadır.

Bu araçlardan öne çıkanı, veriyi saklamak ve işlemek konusunda son derece başarılı olan Apache Hadoop'tur. Benzer şekilde dikkat çeken bir diğer uygulama ise Apache Spark’tır. Diğerlerinin aksine Spark, yerel makinelerde çalışabiliyor. İşlenecek olan verinin büyük bölümünü sistem belleğinde ya da diskinde tutabilmektedir.

Büyük Veri ve İş İmkanları

2020 yılı sonrasında bilgisayar ve veri bilimi ile ilgili birçok alanda istihdam patlaması bekleniyor. Büyük veri ile büyüyen karmaşayı ortadan kaldırmak ve veriyi işlemek için teknik personel ihtiyacı, sürekli artıyor. 2013 yılından bu yana veri bilimi alanında uzmanlaşmış personel ihtiyacı %350 artış gösterdi. Büyük veri ile gelen istihdam fırsatlarından en çok faydalanacak olan alanlar;

Programlama dilleri

Veri görselleştirme

Yapay zeka ve makine öğrenmesi

Veri madenciliği

Kantitatif analiz

Algoritmalar

Veri tabanları ve veri yapıları

şeklinde sıralanabilir. Günümüzde ve özellikle gelecekte altın çağını yaşayacak olan mesleklerdir. Büyük veri ile ilgili algoritma geliştirmek konusunda son derece başarılı olan Python, yazılımcılar için eşsiz bir fırsat sunuyor. Enstitü, bilişim sektöründe ihtiyaç duyulan becerilere sahip kişiler yetiştirebilmek için giderek artan alanda online eğitimler vermektedir. Bu alanlardan biri olan, Yazılım ve Bilişim Eğitimleri ilginizi çekecektir.

İlgili eğitimler: Yazılım ve Bilişim Eğitimleri

Veri Bilimi ve Büyük Veri Analisti

Veri, çağımızın petrolü olarak görülmektedir. Büyük verinin bir sorun olmaktan çıkıp fırsata dönüştürülmesinden bu yana yeni bir ekonominin oluştuğunu söyleyebiliriz. Veri bilimi, toplanan verilerin gerçek bir değere dönüştürülebilmesi için, bilimsel yöntemleri, yazılım tekniklerini kullanarak veri analizi yapan bir alandır. İnsanların veriyi ürettikleri her türlü ortam ve cihazdan elde edilen verilerin analizi için istatistik, bilgisayar bilimi, iş bilgisi gibi çok çeşitli yöntemleri kullanır. Veri bilimi, trendleri ortaya çıkarır ve işletmelerin daha iyi kararlar vermek, daha yenilikçi ürün ve hizmetler oluşturmak için kullanabileceği bilgiler üretir.

Yararlı bilgileri keşfetmek için büyük veri kümelerini toplayan, düzenleyen ve veri analizi yapan kişiyi veri analisti olarak tanımlayabiliriz. Veri analisti, veri madenciliği ve veri denetimi becerilerine sahip olmalıdır. Bu becerilerin yanı sıra istatistiksel beceriler, yapay zekâ, makine öğrenmesi, veri görselleştirme alanlarında da bilgi sahibi olmalıdır.

Özellikle, veri madenciliği ve veri denetimi, herhangi bir veri analisti için gerekli beceriler listesinin başında bulunmaktadır. Veri madenciliği, yeni ve anlamlı bilgiler ortaya çıkarmak için büyük veri tabanlarını inceleme çalışmalarıdır. Veri denetimi, verilerin işletme performansı ve karları üzerindeki etkisini değerlendirmektir.

Veri Analistinin Sahip Olması Gereken Özellikler Nelerdir?

Bir veri analisti, en iyi veri analiz araçları olarak görülen R, Python, SaS gibi programlama dillerinde uzmanlaşarak beklentileri karşılamalıdır. Giderek artan yoğunluk ve karmaşıklıkta, büyük veri çok çeşitli ihtiyaçları da beraberinde getirmektedir. Sorunların ortaya çıkması ve çözülmesi, işletmeler için yeni fırsatlar sağlıyor. Benzer şekilde istihdam konusunda da yeni alanlar açılıyor.

Veri bilimi anlayışının gelişmesi, veri analizi çalışmalarına yön veriyor. Bu durum, çok yönlü yeteneklere sahip nitelikli veri analisti ihtiyacının giderek arttığı anlamına gelir. Son 20 yılda verinin değeri çok daha iyi anlaşılmış durumda. Bu da veri madenciliği çalışmalarının önemi artırmaktadır. Enstitü bünyesinde sunulan online eğitimler sayesinde bilişim dünyasına adım atabilir ve kendinize yeni ufuklar açabilirsiniz.

İzmir Namık Kemal Lisesi mezunuyum. Girişimcilik, Bilgisayar Programcılığı ve Seo eğitimleri aldım. Anahtar kelime çalışması, short-tail ve long-tail keyword kullanımı, anahtar kelime gruplandırması, SEO’yu destekleyen site yapısı, teknik seo, site içi SEO konularında bilgi sahibiyim. 20 yıllık süreç içinde bu konular ile yakından ilgilendim. Pek çok okumalarım oldu. Bu alanlarda içerik üretmekte zorlanmıyorum.